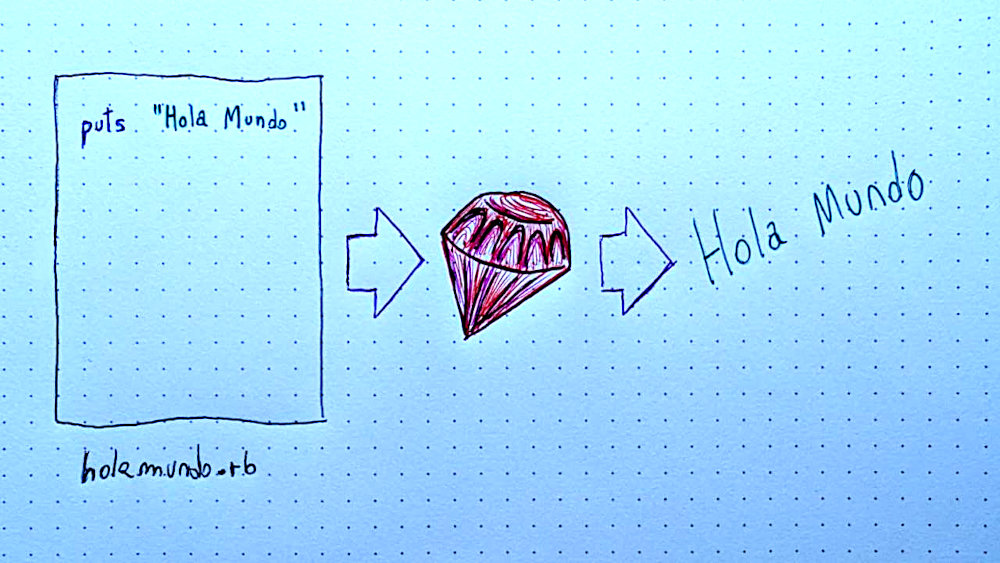

Variable not found

Enlaces interesantes 639

marzo 02, 2026 07:01

Una semana más, vamos con los enlaces a contenidos interesantes que he ido recopilando durante estos días, entre los que destaco algunos posts.

Juan Irigoyen comparte sus experiencias utilizando IA para optimizar SQL Server, en un interesante recorrido por la preparación de un agente Claude capaz de analizar y optimizar consultas SQL, con resultados bastante prometedores.

La depuración puede ser una labor compleja, intensa, a veces frustrante y otras gratificante, pero sin duda forma parte de nuestro día a día. En este artículo, Jeremy D. Miller reflexiona sobre el proceso de depuración, compartiendo consejos para abordar los problemas de manera efectiva-

Y para terminar, una frikada épica a la que llego a través de Microsiervos: un procesador x86 completo implementado únicamente con CSS, sin una sola línea de código JavaScript, y que es capaz de ejecutar código ensamblador compilado para ese procesador.

El resto de contenidos interesantes, a continuación.

Por si te lo perdiste...

- Trocear predicados para mejorar la legibilidad

José M. Aguilar - Shadow properties en Entity Framework Core

José M. Aguilar

.NET

- Logging Profesional en .NET con Serilog: Minimalismo Bien Hecho

Gerson Azabache Martínez - When to Use Builder Pattern in C#: Decision Guide with Examples

Nick Cosentino - A smarter way to learn .NET without reading the docs

David Grace - .NET 11 Preview 1 Arrives with Runtime Async, Zstandard Support, and C# 15 Features

Almir Vuk - Recording metrics in-process using MeterListener

Andrew Lock - Cleaner switch expressions with pattern matching in C#

Bart Wullems - Vector Data in .NET - Building Blocks for AI Part 2

Jeremy Likness - Is it faster to index into an array or use switch statement for lookups?

Jiří Činčura - Semantic Kernel in C#: Complete AI Orchestration Guide

Nick Cosentino - .NET Synchronisation APIs - Part 1

Ricardo Peres - Brave new C#

PVS-Studio - Developing an MCP Server with C#: A Complete Guide

NDepend Team

ASP.NET Core / ASP.NET / Blazor

- Cookie Banners Won't Save You From ISO 27701

Martin Stühmer - Stop Wrestling with JavaScript: htmxRazor Gives ASP.NET Core the Component Library It Deserves

Chris Woodruff

Azure / Cloud

- How to Troubleshoot Azure Functions Not Visible in Azure Portal

Vikas Gupta - Optimising AI Costs with Microsoft Foundry Model Router

Lee Stott

Conceptos / Patrones / Buenas prácticas

- Rename, para entender mejor

Fran Iglesias - Read Replicas Are NOT CQRS (Stop Confusing This)

Peter Ritchie - How to Avoid Code Duplication in Vertical Slice Architecture in .NET

Anton Martyniuk - TDD as induction

Mark Seemann - On Debugging Problems

Jeremy D. Miller

Data

- Optimización en Sql Server usando IA

Juan Irigoyen - Emulating GETDATE() on Azure SQL Database

Joe Obbish - Polymorphic Relationships in EF Core: Three Approaches

Ali Hamza Ansari - The Hidden Work Behind SELECT TOP in SQL Server

Jared Westover

Machine learning / IA

- Primeros pasos con Microsoft Agent Framework: construyendo un chatbot de soporte con C#

Isaac Ojeda - Microsoft Agent Framework is Release Candidate! Let’s Go

Bruno Capuano - Redefining the Software Engineering Profession for AI

Mark Russinovich & Scott Hanselman - [TIP] How to Add MCP Servers to Claude Code and Gemini CLI on Windows

Juan Luis Guerrero

Web / HTML / CSS / Javascript

- Playing CSS-defined animations with JavaScript

Ben Hatsor - Loading Smarter: SVG vs. Raster Loaders in Modern Web Design

Mariana Beldi - Virtual Scroll-Driven 3D Scenes

Gunnar Bachelor - Goodbye innerHTML, Hello setHTML: Stronger XSS Protection in Firefox 148 - Mozilla Hacks

Tom Schuster, Frederik Braun & Christoph Kerschbaumer - A Complete Guide to Bookmarklets

Declan Chidlow - An Exploit ... in CSS?!

Lee Meyer - A Guide to Jakob’s Law in Web Development

Adrew Peterson - React 19 Suspense for Data Fetching: A New Model for Async UI

Prashant Yadav - We deserve a better streams API for JavaScript

James M. Snell - Yet Another Way to Center an (Absolute) Element

Juan Diego Rodríguez - The Hidden Trick of Style Queries and if()

Temani Afif - Building Async Page Transitions in Vanilla JavaScript

Valentin Mor

Visual Studio / Complementos / Herramientas

- cURL para desarrolladores .NET: guía práctica, real y profesional

Gerson Azabache Martínez - GitHub Copilot CLI is now generally available

GitHub Copilot Team - The Dongle Died at Midnight – WinForms Agent Saved my German Mom's Business Trip

Klaus Loeffelmann - Introducing Agentic UI Builder: Build Complete Enterprise UIs with Syncfusion MCP Servers

Lokeshwaran Ragavan - Run OpenClaw Securely in Docker Sandboxes

Oleg Selajev - XAML.io v0.6: Share Running .NET Code With a Link

XAM.io Team - Stop Drawing Architecture Diagrams Manually: Meet the Open-Source AI Architecture Review Agents

Shivam Goyal - VS Code: Building Long-Distance Next Edit Suggestions

Vikram Duvvur, Gaurav Mittal & Benjamin Simmonds

.NET MAUI

- Simplifying Grid Layout in .NET MAUI Using Extension Methods

Leomaris Reyes - C# Expressions in XAML: throw out your converters

Steven Thewissen - How to Add Email and Toast Reminders to a .NET MAUI Scheduler

Yuvaraj Gajaraj

Otros

- What is egoless programming?

Ivan Kranjec - x86 CPU made in CSS

Lyra Rebane

Publicado en Variable not found.

Picando Código

Migrando código de GitHub a Codeberg

febrero 26, 2026 12:00

Sigo con mi migración a un uso más sano de internet, computadoras, la vida, el universo y todo lo demás. Además de estar alojando mi servidor Git con Forgejo, también empecé a migrar mis cosas de GitHub a Codeberg. Mi idea es por lo menos todos mis proyectos personales irlos borrando de GitHub. Voy a tenerlos tanto en Codeberg como mi instancia local privada de Forgejo.

Eventualmente éstos sistemas van a implementar la federación. Ahí buscaré una forma de alojar mi propia instancia en algún servidor remoto. Me gusta mucho la idea de tener una instancia propia y personal. Y desde ahí compartir mi código de manera pública y colaborar con código abierto y software libre. Haría el trabajo que hacía GitHub, pero de forma autónoma y sin el veneno de Microslop encima.

Voy bastante lento, sinceramente es un trabajo aburrido y monótono. Además después de pasar todo el día trabajando (gran parte de eso interactuando con GitHub), me quedan pocas ganas a la tarde/noche de seguir haciendo eso. Pero va saliendo.

Muchos de los repositorios los he ido compartiendo acá en el blog, así que tengo que ir buscando los enlaces para cambiarlos a su dirección nueva y guardar los posts o comentarios. Ya he cambiado algunos y borrado los repositorios enteros de GitHub. No me interesa qué registro quede en mi perfil de GitHub de lo hecho en el pasado, ya no va a ser mi perfil por defecto de código abierto en internet.

Tengo un par de cosas alojadas en GitHub Pages que voy a tener que sacar de ahí. Es todo contenido estático, así que es fácil moverlas a un servidor web común (incluso el mismo servidor donde está alojado este blog). Por cada uno tengo que buscar un hogar nuevo y cambiar dónde apunta el dominio.

El otro tema es la automatización. Las acciones de GitHub son bastante convenientes (cuando funcionan) a la hora de automatizar (excepto a la hora de querer testearlas). Creo que Codeberg tiene algo compatible con eso, pero no lo he revisado. Lo único automatizado que tengo es mi sitio web personal. Es un sitio estático generado con Middleman, pero tiene un montón de contenido que se obtiene dinámicamente. Por eso tengo una acción que actualiza el sitio automáticamente. De repente lo muevo a un servidor y programo un cron en mi Raspberry Pi para que lo genere y suba los archivos por FTP como en los viejos tiempos.

Desde que lo compró Microslop, GitHub se ha ido transformando en un producto cada vez peor. ¡Como todo lo que toca Microslop! Lamentablemente voy a tener que seguir usando GitHub, en el trabajo particularmente hacemos casi todo alrededor de GitHub. Lo cual tiene sentido, como he dicho anteriormente, mi teoría es que GitHub va a ser a Git lo que Jira es a gestión de proyectos. Lo van a terminar usando empresas a las que convencieron que necesitan comprar este producto para hacer desarrollo de software. También voy a mantener por ahora un mirror de mi plugin de WordPress, hasta que vea de coordinar con el otro mantenedor para mudarlo a Codeberg.

Además de todos los problemas éticos que tengo con GitHub, la aplicación está cada día está más inusable. Leí algo de que lo llenaron de React y esto hace que todas las interacciones sean lentas y poco confiables. Además Microslop viene acosándonos con Clippy (ahora con el nombre de copiloto) cada vez más. Esta gente no entiende que no es no.

Cualquier proyecto personal nuevo de código abierto en el que trabaje ya lo voy a tener alojado directamente en Codeberg, pero mientras sigo lentamente migrando de a pocos proyectos por semana...

El post Migrando código de GitHub a Codeberg fue publicado originalmente en Picando Código.Variable not found

Enlaces interesantes 638

febrero 23, 2026 07:02

Otra semana de contenidos interesantes en la web 🙂

Según Milan Milanović, solo 3–4 horas al día son realmente productivas al programar, porque el resto del tiempo se pierde por límites cognitivos, reuniones e interrupciones. Si conseguimos optimizar ese tiempo, mejorará nuestro rendimiento y la calidad del software que desarrollemos, mucho más que intentar trabajar más horas.

Bruno Capuano nos habla sobre la generación de embeddings, tanto de texto como de imágenes, en nuestro equipo local, y nos presenta una biblioteca de código abierto que ha desarrollado para facilitar esta tarea en .NET.

¿En qué se diferencian las colecciones Readonly de las Immutables? ¿Y qué son las colecciones Frozen? Pues aunque parezcan lo mismo, Davide Bellone nos muestra que son cosas muy diferentes.

La primera preview de .NET 11 ya trae algunas novedades interesantes. Steven Giesel nos muestra que el nuevo runtime async es una realidad, y que va a mejorar mucho el rendimiento de las aplicaciones asíncronas.

El resto de enlaces a contenidos interesantes, a continuación.

Por si te lo perdiste...

- Propiedades semi-automáticas en C#

José M. Aguilar - Evaluación en cliente de EF Core: sus peligros y cómo evitarla

José M. Aguilar

.NET

- Logging profesional en .NET: Diseña Telemetría, no Prints

Gerson Azabache Martínez - Collection Expression Arguments in C# 15 are "out"

Steven Giesel - Writing a native VLC plugin in C#

Martin Finkel - Introducing the Coding Agent Explorer (.NET)

Tore Nestenius - New runtime async is hitting .NET 11

Steven Giesel - Exploring .NET 11 Preview 1 Runtime Async: A dive into the Future of Async in .NET

Laurent Kempé - How to Implement Abstract Factory Pattern in C#: Step-by-Step Guide

Nick Cosentino - Creating standard and "observable" instruments

Andrew Lock - Readonly vs Immutable vs Frozen in C#: differences and (a lot of) benchmarks

Davide Bellone - Deep C# - Multicast Delegates and Events

Mike James - T4 templates on modern .NET

Ian Griffiths - Getting Started with .NET Scheduling in Hangfire

Peter Ritchie - NuGet Packages: The Suppliers You Forgot to Audit

Martin Stühmer

ASP.NET Core / ASP.NET / Blazor

- Swagger's missing in .NET 10

David Grace - What's new for the Microsoft Fluent UI Blazor library 4.14

Vincent Baaij - Add application security to the swiyu generic management verifier APIs using OAuth

Damien Bowden - ASP.NET Core with Needlr: Simplified Web Application Setup

Nick Cosentino - How to Set Up Production-Ready Monitoring With ASP.NET Core Health Checks

Anton Martyniuk - Creating Drag-and-Drop ListBoxes in Blazor

Héctor Pérez - Building Real-World Web Apps with ASP.NET Core Razor Pages

David Ramel

Azure / Cloud

Conceptos / Patrones / Buenas prácticas

- Timsort Algorithm

Neo Kim

Data

- SQL Server Long-Running Query Detection: How to Find and Monitor Slow Queries

Edward Pollack - ASP.NET Core warmup EF Core

Karen Payne

Machine learning / IA

- Presentamos GPT‑5.3‑Codex‑Spark

OpenAI - Gemini 3.1 Pro: Announcing our latest Gemini AI model

Gemini Team - Local Embeddings in .NET — The Easy Way & Building RAG in .NET with Local Embeddings — 3 Approaches, Zero Cloud Calls & * Local Image Embeddings in .NET — CLIP + ONNX

Bruno Capuano - The Most Popular AI Tools: What Developers Use and Why

Conrad Schwellnus - WebMCP – a much needed way to make agents play with rather than against the web

Christian Heilmann - I Intercepted 3,177 API Calls Across 4 AI Coding Tools. Here's What's Actually Filling Your Context Window.

Lars de Ridder - Decision Tree Regression from Scratch Without Pointers or Recursion Using C#

James McCaffrey - Microsoft Agent Framework Reaches Release Candidate

Shawn Henry - Migrate your Semantic Kernel and AutoGen projects to Microsoft Agent Framework Release Candidate

Dmytro Struk & Shawn Henry

Web / HTML / CSS / Javascript

- Accesibilidad web 2026: WCAG 2.2, IA y ley europea

Marco Romero - Performance-Optimized Video Embeds with Zero JavaScript

Stefan Bauer - jQuery 4.0.0 Support: What’s New + Kendo UI Has You Covered

Nikolay Penev - Fun with TypeScript Generics

Adam Rackis - Anchored Menus and a Lesson in Scoping

Chris Coyier - Optimizing JavaScript for the Edge Runtime

Jonathan Gamble - Justifying text-wrap: pretty

Alex Kladov - Choosing a React Animation Library: Performance Trade-Offs in Real Apps

Sumankumar G. - Spiral Scrollytelling in CSS With sibling-index()

Lee Meyer - Interop 2026

Geoff Graham - New to the web platform in January

Rachel Andrew - Three Plug-N-Play CSS Libraries

Raymond Camden - Distinguishing "Components" and "Utilities" in Tailwind

Zell Liew - Angular 21: Internal Mechanics, ARIA, and AI-Powered Coding!

Angular Team - API Security Best Practices: A Developer’s Guide to Protecting Your APIs

The Postman Team - Potentially Coming to a Browser :near() You

Daniel Schwarz - Death to Scroll Fade!

Chris Coyier

Visual Studio / Complementos / Herramientas

- Tus contenedores no son tan seguros como crees: estrategias de mitigación para Docker y Kubernetes

CampusMVP - Dear Copilot, can you help me with SQL?

Thiago Henrique da Silva

.NET MAUI

- .NET 11 Preview for .NET MAUI: Simplify XAML with Inline C# Expressions

Sri Radhesh Nag Subash Sankar

Otros

- Autómatas victorianos, gargantas de cuero y redes neuronales: Anatomía secreta de las máquinas parlantes

María Gómez - You can code only 4 hours per day. Here’s why.

Milan Milanović - SaaSpocalipsis: el mercado ya ha descontado algo que muchos desarrolladores aún no han interiorizado

Alberto Díaz Martín

Publicado en Variable not found.

Picando Código

Reus 2 + DLC Praderas - Steam

febrero 19, 2026 07:00

Uno es el universo, eterno, sólo, aburrido. Hasta que una chispa de vida se manifiesta a través de muchas voces con el nombre de Humanidad. Son ambiciosos y acuden a ti buscando ayuda, te llaman Naturaleza. Motivado por su creatividad, creas gigantes elementales que te ayuden a darle forma al mundo. Ayudando a los humanos con sus ambiciones, comienza un nuevo capítulo para proveeer de vida al universo.

Con esta introducción majestuosa comienza la aventura en Reus 2, un juego de estrategia y simulación que nos pone en el lugar de una deidad al mando del sistema solar. Cada partida nos presenta con un planeta desolado que tenemos que terraformar para hacer habitable. Inicialmente tenemos 3 gigantes elementales disponibles, pero a medida que avanzamos en el juego vamos habilitando gigantes nuevos. También está la posibilidad de habilitar todo desde un principio, pero en lo personal preferí ir descubriendo cada recurso nuevo a medida que juego.

Cada gigante permite terraformar un bioma distinto: océano, selva, bosque, desierto, pradera, sabana y más. A su vez, son los encargados de agregar flora, fauna y minerales al planeta. Inicialmente tenemos una tribu o grupo, pero a medida que avanzamos van a mudarse más humanos, y tenemos que crear un hábitat para cada uno. Cada bioma permite flora, fauna y minerales distintos, aunque algunos están disponibles en más de un bioma. En el océano tenemos algas, peces, en la tierra árboles con frutos como arándanos y bananas, conejos y carpinchos, entre otros.

Dependiendo de las necesidades de cada grupo humano, tenemos que equilibrar el medio ambiente con estas bióticas para proveer tecnología, riqueza, alimento y biodiversidad. Reus 2 tiene un montón de cosas por aprender. Pero el juego mismo reconoce que es imposible aprender todo al mismo tiempo, así que aconseja ir aprendiendo a nuestro tiempo. Casi todo tiene un tooltip con explicaciones. La primera misión es un tutorial que resulta bastante esencial y nos enseña lo básico. No hay que agobiarse, a medida que vamos jugando más, le vamos agarrando más la mano y aprendiendo cómo gestionar mejor el planeta.

Hay muchos factores a tener en cuenta y esto hace que sea importante la estrategia que vamos desarrollando con la experiencia. A medida que avanzamos y habilitamos nuevas características, aumenta un poco la complejidad. En algunos momentos se siente como un juego de puzzles tratando de equilibrar los distintos recursos de cada bioma para proveer a cada civilización lo que requiere para prosperar. Pero es muy entretenido y tiene ese factor adictivo de juegos de simulación similares. Es muy satisfactorio completar un planeta e ir viendo cómo avanzamos y nuestro sistema solar se va poblando de más planetas.

Está divertido el loop de empezar un planeta nuevo, jugar y avanzar en las distintas épocas hasta dar por terminado un planeta. Al final recibimos recompensas en relación a las metas que superamos y cómo ayudamos a los humanos. Podemos empezar un planeta de nuevo con lo aprendido y las especies, habilidades o hasta gigantes nuevos a probar. Esto resulta bastante liviano, y como todo juego de estrategia podemos probar cosas distintas para obtener resultados variados en cada nuevo intento.

Cuando tenemos más de un grupo de humanos, empiezan a interactuar entre sí. A veces hacen trueque y generan amistad entre ellos. Otras veces deciden atacarse o robarse recursos entre sí. En esos momentos podemos no intervenir y dejar que se peleen entre ellos. Pero también podemos despertar el espíritu kaiju de nuestros gigantes elementales y eliminar al grupo conflictivo con catástrofes naturales como un tsunami. Las animaciones de los humanos son bastante entretenidas y con mucha personalidad, tanto cuando encuentran cosas nuevas como cuando interactúan entre ellos o son atacados por una catástrofe.

Si los humanos se enojan, pueden llegar a querer atacar a nuestros gigantes elementales. Podemos aceptarlo o enseñarles una lección, enviando un terremoto, fuego y otros desastres naturales para mostrarles quién manda. Es muy divertido, y cuando iniciamos un ataque la música cambia a algo bien dramático que esperaríamos de una película de ataque de monstruos gigantes.

El arte del juego está muy bueno, la fauna, flora, y minerales se van haciendo reconocibles y con el tiempo vamos a tener que ir aprendiendo más por cada bioma. Los diseños de los gigantes elementales me gustan, representativos de sus biomas y con apariencia de amables y bonachones. Pero donde nos hagan enojar, los podemos hacer comportar como verdaderos monstruos. Me gusta el estilo tranquilo y relajante del juego, por eso cuando los humanos se ponen violentos respondo con todo el poder elemental de los gigantes

Recientemente se lanzó el tercer DLC para Reus 2 Praderas. Este incluye:

- Nuevo bioma - Estepa, con un aspecto renovado para el Gigante Jangwa y más de 65 nuevas especies de flora y fauna, como el Bisonte y el Perro de las Praderas.

- Nueva mecánica de incendios, donde el estrés del suelo provoca fuegos que generan efectos en cadena, fortaleciendo y regenerando la naturaleza.

- 4 nuevos líderes: Agricultor, Cultista, Arquitecto y Astronauta, cada uno con estilos de juego únicos.

- 3 nuevas eras: Ciudad Fabulosa, Planeta Celestial y Sueño Biocinético, que abren caminos inéditos para la evolución de la humanidad.

La verdad que estos DLC están bastante completos, le agregan un montón de diversidad y son una buena razón para volver a jugarlo.

El juego está disponible en Steam, Nintendo Switch y XBox. En Steam está publicado en Windows, pero lo he estado jugando con Proton 10.0-4 en Garuda Linux y funciona perfecto. También está verificado como compatible con Steam Deck. Es un juego de estrategia muy entretenido al que vale la pena volver para jugar "un planeta más".

El post Reus 2 + DLC Praderas - Steam fue publicado originalmente en Picando Código.Navegapolis

BurlaBurlando

febrero 18, 2026 06:51

Para desaprender cómo se hacen (o hacían) las cosas sin IA, esta Navidad estuve jugando a hacer un programa con un asistente.

La idea era construir algo para retar y evaluar: la capacidad de un asistente al trazar y ejecutar planes de codificación, y la capacidad de comprensión léxica y razonamiento lógico de los LLM’s.

He empleado:

– Codificación: Antigravity con Gemini 3 Pro (High)

– Imágenes: ChatGPT 5.2 Thinking

– Retos de razonamiento y léxico que muestra el juego: Gemini 3 Pro (High)

– Asesoramiento para levantar y configurar un servidor AWS lihthsail: ChatGPT 5.2 Thinking

Me ha parecido increíble (y creo que también inquietante) el «aumento» que esto puede dar a alguien que tenga conocimientos básicos (fui programador -no muy bueno- y hace más de 20 años).

Por si además puede ser útil  dejo el resultado en burlaburlando.com (el dominio de un proyecto que nunca hice).

dejo el resultado en burlaburlando.com (el dominio de un proyecto que nunca hice).

Toda la codificación, preguntas y retos lógicos que genera, los ha desarrollado una IA.

La entrada BurlaBurlando se publicó primero en Navegápolis.

Variable not found

Lambdas estáticas en C#: cómo y cuándo usarlas

febrero 17, 2026 07:05

No es algo que se utilice habitualmente, y a veces incluso es un detalle desconocido por los desarrolladores, pero las funciones lambda de C# pueden ser estáticas. Y no es porque sea algo nuevo, pues esta característica se introdujo en la versión 9.0 del lenguaje en 2020... simplemente son esos pequeños detalles que se van añadiendo al lenguaje sin hacer mucho ruido, y que a veces pasan desapercibidos.

De hecho, el uso de lambdas estáticas puede ayudarnos a escribir un código más seguro y predecible, además de tener cierto impacto en el rendimiento de nuestras aplicaciones, por lo que merece la pena conocerlas y saber cuándo y cómo usarlas.

En este post vamos a ver qué son las lambdas estáticas, cómo se implementan y cuándo y por qué deberíamos usarlas.

Lambdas estáticas

Al igual que ocurre con los métodos o funciones en C#, las funciones lambda pueden ser estáticas, es decir, pueden vivir fuera del contexto de una instancia de clase, y se implementan simplemente añadiendo la palabra clave static delante de la definición de la lambda:

var suma = static (x, y) => x + y;

Esto mismo podemos verlo en escenarios más complejos, como en consultas LINQ sobre colecciones u orígenes de datos, ya sea usándolas como delegados o bien como árboles de expresión:

int[] nums = [1, 2, 3, 4, 5];

var sum = nums.Where(static x => x % 2 == 0).Sum(); // Suma los pares

Console.WriteLine(sum); // Imprime 6

En cualquier caso, la declaración de una lambda como estática hace que aparezcan ciertas restricciones en su implementación. En primer lugar, las lambdas estáticas no pueden capturar variables de instancia, pues no tienen acceso a this ni a las variables o métodos de instancia de la clase en la que se definen.

Tampoco pueden capturar variables locales ni parámetros del método que las contiene, a menos que se pasen explícitamente como argumentos.

En otras palabras, deben ser funciones puras, que dependen únicamente de sus parámetros de entrada.

Esto, que a priori puede parecer una limitación, en realidad es una de las principales ventajas de las lambdas estáticas, ya que, al no depender de ningún factor externo, su comportamiento será más predecible y fácil de implementar y depurar.

Observa por ejemplo el siguiente caso, en el que la lambda duplicate captura la variable factor del contexto que la contiene, y hace que su valor dependa de ella:

int factor = 2;

var duplicate = (int x) => x * factor; // No captura el valor de 'factor',

// sino la referencia a la variable

Console.WriteLine(duplicate(2)); // Imprime 4

factor = 3;

Console.WriteLine(duplicate(2)); // Imprime 6

Fíjate que aunque llamamos a la lambda duplicate con el mismo parámetro, el resultado es diferente porque la variable factor ha cambiado su valor en el segundo caso.

Esto puede provocar errores difíciles de detectar y depurar. De hecho, el entorno de desarrollo (IDE) nos avisa de que la lambda está capturando una variable del contexto cuyo valor es modificado, por lo que puede provocar efectos inesperados:

Al convertir la lambda en estática, el compilador nos avisará de que no puede capturar variables del contexto, por lo que nos veremos obligados a usar constantes o bien a pasar los valores como parámetros; en cualquiera de los dos casos, la lambda será siempre una función pura y su comportamiento será totalmente predecible:

int factor = 2;

var duplicate = static (int x) => x * factor; // Error CS8820: A static anonymous function

// cannot contain a reference to 'factor'.

var duplicate = static (int x) => x * 2; // Correcto, factor es un valor constante

var multiply = static (int x, int factor) => x * factor; // Correcto, factor se pasa como parámetro

Pero además, es importante saber que, cuando se invoca una lambda que captura alguna referencia externa, el compilador genera un objeto de cierre (o closure) para almacenar esas referencias, lo que implica una sobrecarga adicional en tiempo de ejecución y un mayor consumo de memoria.

Por tanto, cuando usemos lambdas estáticas, además de tener un código más seguro y determinista, podemos estar seguros de que no se generará ningún objeto de cierre, por lo que el rendimiento y consumo de memoria serán óptimos.

Benchmarks

El impacto del uso de objetos de cierre en el rendimiento y consumo de memoria puede ser significativo en escenarios donde se usan muchas lambdas que capturan referencias, como en bucles o en operaciones con colecciones. Esto puede verse en el siguiente resultado de un benchmark, donde comparamos cuatro escenarios diferentes:

- una lambda normal sin capturas,

- otra lambda normal que captura una propiedad de instancia,

- una tercera que captura una variable local,

- y una lambda estática sin capturas.

| Method | Mean | Error | StdDev | Median | Gen0 | Allocated |

|----------------------------- |----------:|----------:|----------:|----------:|-------:|----------:|

| NormalLambdaWithNoCapture | 0.0031 ns | 0.0033 ns | 0.0027 ns | 0.0023 ns | - | - |

| NormalLambdaWithCapture | 4.8063 ns | 0.0654 ns | 0.0612 ns | 4.8035 ns | 0.0077 | 64 B |

| NormalLambdaWithLocalCapture | 7.0980 ns | 0.1036 ns | 0.0969 ns | 7.0805 ns | 0.0105 | 88 B |

| StaticLambda | 0.0039 ns | 0.0035 ns | 0.0033 ns | 0.0046 ns | - | - |

Lo primero que llama la atención es que las lambdas normales que capturan referencias (ya sean de instancia o locales) son muchísimo más lentas que las que no capturan nada, y además generan consumo de memoria (reservan memoria en el heap y provocan recolecciones de basura).

Las lambdas que no capturan referencias prácticamente consiguen el mismo rendimiento, con una diferencia inapreciable. Y, eso sí, ninguna de las dos genera sobrecarga ni consumo de memoria.

Entonces, ¿cuándo deberíamos usar lambdas estáticas?

En general, salvo que necesitemos capturar referencias del contexto, será conveniente utilizar lambdas estáticas siempre, ya que nos aseguramos de que nuestro código es más seguro y predecible, sin perder en eficiencia o consumo de memoria.

Publicado en Variable not found.

Picando Código

List Category Posts v0.94.0 - Año nuevo, "vulnerabilidad crítica de seguridad" nueva

febrero 16, 2026 09:24

![]() Desde octubre la cosa estaba bastante tranquila en el frente List Category Posts, el plugin que desarrollé para WordPress. El año pasado empezaron los reportes de seguridad de supuestas vulnerabilidades del plugin. Inicialmente demoré demasiado en corregirlo, por lo que Wordfence alarmó a todos los usuarios de List Category Posts con una advertencia de que sufría de una vulnerabilidad.

Desde octubre la cosa estaba bastante tranquila en el frente List Category Posts, el plugin que desarrollé para WordPress. El año pasado empezaron los reportes de seguridad de supuestas vulnerabilidades del plugin. Inicialmente demoré demasiado en corregirlo, por lo que Wordfence alarmó a todos los usuarios de List Category Posts con una advertencia de que sufría de una vulnerabilidad.

La advertencia debió ser bastante alarmista, pero el peligro era prácticamente inexistente. Las vulnerabilidades no podían ser explotadas, a menos que el sistema ya estuviera comprometido y un atacante tuviera acceso al panel de administración. Documenté estas ocurrencias en varias ocasiones. En capítulos anteriores de Picando Código:

- Arreglada vulnerabilidad CVE-2025-47636 en List Category Posts

- Publicado List Category Posts v0.92.0 con mejoras en "seguridad"

- Nada que ver en las audaces aventuras de desarrollar un proyecto de código abierto popular

- List Category Posts v0.93.0 donde se corrigen "problemas" y re-aprendo PHP

En fin, acá estamos de nuevo con otra ocasión donde se reportaron nuevos problemas. Mientras corregía uno, me llegó otro correo de Wordfence con otro similar, y eventualmente el mismo reportado por Patchstack. Está bueno esto de entender cómo funciona el proceso en el que se informa responsablemente de un CVE con su ID, puntaje y demás. Este último tiene el id CVE ID: CVE-2026-0553.

A partir de hoy está disponible List Category Posts v0.94.0, que corrige dos "vulnerabilidades" que realmente no lo son tanto. Ya que estaba decidí actualizar otra parte del código, a ver si resuelve un problema reportado en el foro que no pude reproducir en mi ambiente de desarrollo.

Escribí el código medio rápido porque lo quería sacar cuanto antes. Pero por suerte está Klemens que ha aportado un montón de código y se acuerda de cosas que yo no. Siempre lo menciono en los Pull Requests porque respeto mucho su opinión y generalmente sabe más que yo de PHP y WordPress. Probé el código en local y confirmé que las vulnerabilidades reportadas habían sido resueltas sin romper nada en general y que los tests pasan. Pero Klemens me recordó que ya había resuelto esos mismos problemas anteriormente. Así que gracias a su revisión del código, lo mantuve más consistente con lo que había hecho en ocasiones anteriores.

El plugin tiene un puntaje muy bueno en el rating de WordPress.org, 4.7 de 5. La mayoría de los usuarios están bastante contentos, y eso está bueno. Se me dio por ir a mirar si había algo nuevo, y de hecho encontré una reseña escrita hace algo más de un mes que me dejó muy contento.

Titulada "Fantastic", la reseña dice: Este es un plugin absolutamente asombroso porque se puede usar de tantas formas diferentes desde por ejemplo crear una página de navegación que lista las páginas categorizadas con "Navegación", a crear "Páginas relacionadas", etc. Hasta puede usarse con etiquetas, no sólo categorías. Y más. Es la idea, por más que empezó como una herramienta que uso para mi blog, poder compartirla y hacerle la vida más fácil a otra gente con el mismo código.

Wordfence generalmente me enviaba el reporte por email. Pero recientemente publicaron un portal para gestionar vulnerabilidades. Asumí que por ahí venía la mano de tanto reporte. Por su lado tienen un interés comercial. Por el de nuestro plugin, todo el trabajo es voluntario y por el simple hecho de compartirlo con la comunidad. Mi respuesta inicial fue que no quería crearme una cuenta más en internet, si era posible que me avisaran por correo de todas formas. Después de un tiempo me convencieron. Pero intenté hacerme una cuenta, y no funcionaba el token que me habían mandado, así que me dí por vencido.

Me volvieron a convencer más recientemente y creé una cuenta. Ahora sólo tenía que agregar mis plugins de WordPress y verificar que eran míos. Por alguna razón, el sistema detecta que el código está en GitHub, y me pide que suba un archivo a la raíz del dominio para verificar que soy el dueño del código... Sí, me pide que suba un archivo de texto a la raíz de github.com. Estamos en 2026 y estas cosas salen a producción. Una empresa de expertos en seguridad. Les escribí al respecto, pero creo que decidieron ignorarlo y no me han dicho nada. Pero bueno, seguiré pidiendo que me manden los reportes por correo electrónico como se debe...

List Category Posts es un plugin para WordPress, es software libre publicado bajo la GPLv2. El código fuente está disponible en Codeberg, en GitHub y en WordPress.org (SVN). Se puede descargar desde el sitio de plugins de WordPress.

El post List Category Posts v0.94.0 - Año nuevo, "vulnerabilidad crítica de seguridad" nueva fue publicado originalmente en Picando Código.Variable not found

Enlaces interesantes 637

febrero 16, 2026 07:31

Mucho contenido interesante en la recopilación de enlaces de esta semana, entre los que me gustaría destacar algunas lecturas a las que, como mínimo, vale la pena echar un vistazo.

Ha llegado la primera preview de .NET 11, con un buen puñado de novedades en el runtime, librerías, SDK, C#, ASP.NET y Blazor. En el post del anuncio oficial podéis encontrar el listado completo y enlaces para profundizar en cada una de ellas.

Tenemos un doblete de Ricardo Peres sobre Entity Framework Core. Primero, profundiza en la forma de mapear distintos tipos de relaciones y las novedades que se han introducido en las últimas versiones para facilitar esta tarea, y luego nos habla sobre la validación de estado de entidades en este framework.

GitHub Copilot es indudablemente una herramienta alucinante, pero a veces no es fácil saber qué modo de uso es el más adecuado para cada tarea. José Manuel Alarcón nos lo explica en este artículo.

Y siguiendo con dobletes, el mismo autor nos trae un interesante artículo analizando cómo determinadas narrativas negativas amplificadas en redes sociales pueden generar frustración y malas decisiones en desarrolladores júnior, y propone estrategias prácticas para reconocer ese sesgo y protegerse de él.

Por último, James Randall comparte cómo ha cambiado la programación en 40 años y cómo ha cambiado también su relación con ella. Si tienes ya unos añitos, probablemente te sentirás identificado.

El resto de enlaces, a continuación.

Por si te lo perdiste...

- Invalidar el contenido cacheado por el tag helper "cache" de ASP.NET Core MVC

José M. Aguilar - Abrir Gmail y Google Calendar con una cuenta específica, y cómo anclarlos en la barra de tareas de Windows

José M. Aguilar

.NET

- .NET 11 Preview 1 is now available!

.NET Team - Autentication y Authorization en .NET

Fernando Escolar - Abstract Factory vs Factory Method Pattern in C#: Key Differences Explained

Nick Cosentino - Global Phone Number and Postal Code Validation Made Easy

David McCarter - Implementing strongly-typed IDs in .NET for safer domain models

Ali Hamza Ansari - How to Start a New .NET Project in 2026

Anton Martyniuk - Automatic Service Discovery in C# with Needlr: How It Works

Nick Cosentino - Writing a .NET Garbage Collector in C# - Part 7: Marking handles

Kevin Gosse

ASP.NET Core / ASP.NET / Blazor

- ASP.NET Core Security Explained: Modern Authentication, Authorization, and JWT

Arulraj Aboorvasamy - Isolate the swiyu Public Beta management APIs using YARP

Damien Bowden - Secure Image Uploads in Blazor Rich Text Editor Using JWT

Saravanan G. - Customizing Validation Messages in Blazor Forms

Héctor Pérez - Mastering the ASP.NET Core Request Pipeline: Middleware, Endpoint Filters, and Scalable API Architecture

Sudhir Mangla - Implementing Zero Trust with Resource Isolation

Maarten Balliauw - Announcing Blazorise 2.0

Mladen Macanović

Azure / Cloud

- Cloudflare for Startups: Hasta 250.000 USD en servicios para tu proyecto

Chema Alonso - Announcing Application Insights SDK 3.x for .NET

MattMC

Data

- Cuando usar FindAsync o FirstOrDefaultAsync en EF Core

Gerson Azabache Martínez - Modern Mapping with EF Core & EF Core State Validation

Ricardo Peres - How LeftJoin and RightJoin Work in EF Core .NET 10

David Grace - Entity Framework Core 10 provider for Firebird is ready

Jiří Činčura - SQL SERVER – Execution Plans and Indexing Strategies – Quick Guide

Pinal Dave - Azure SQL’s Native JSON Type: Optimized for Performance

Shrusti Kolsur - Stop Hoarding Personal Data in Entity Framework

Martin Stühmer

Machine learning / IA

- Haz que tus custom agents sean subagents de GitHub Copilot

Gisela Torres - Building an AI Skills Executor in .NET with Azure OpenAI

Rand Random - Microsoft Agent Framework: Exposing an Existing AI Agent as an MCP Tool – Jamie Maguire

Jamie Maguire - Testing ads in ChatGPT

OpenAI

Web / HTML / CSS / Javascript

- Announcing TypeScript 6.0 Beta

Daniel Rosenwasser - Trying to Make the Perfect Pie Chart in CSS

Juan Diego Rodríguez - What to Expect in Angular 22

Kelly Vatter - Integrating HTMX with React and Next.js for Dynamic HTML Updates

Satheeskumar S. - How to Open and Render DOCX Files in the Browser with React

Ramkumar Ravy - Approximating contrast-color() With Other CSS Features

Kevin Hamer - Image Optimization in Angular Applications

Christian Nwamba - Making a Responsive Pyramidal Grid With Modern CSS

Temani Afif

Visual Studio / Complementos / Herramientas

- GitHub Copilot: cuándo usar los modos Ask, Edit, Agent y Plan según la tarea

José Manuel Alarcón - 5 open-source Windows 11 apps you didn't know you needed

Mauro Huculak - How to Convert an HTML to an EXE file

Alex Marin - GitHub Copilot Testing for .NET Brings AI-powered Unit Tests to Visual Studio 2026

McKenna Barlow - Unlock language-specific rich symbol context using new find_symbol tool

Mike Gine

.NET MAUI

- Visualizing Supply Chain Metrics in .NET MAUI with Charts and Gauges

Hariram Subramanian - Why Your .NET MAUI Layout Breaks Across Devices and How to Fix It

Anandh Ganesan - Exploring Compiled Bindings in .NET MAUI

Leomaris Reyes - Building a Support Ticket Dashborad with .NET MAUI DataGrid

Farjana Parveen

Otros

- Desarrollador junior y frustrado con tu trabajo: cómo evitar el sesgo de negatividad online

José Manuel Alarcón - I Started Programming When I Was 7. I'm 50 Now, and the Thing I Loved Has Changed

James Randall

Variable not found

Enlaces interesantes 636

febrero 09, 2026 07:02

En los enlaces interesantes de esta semana, creo que vale la pena destacar el post de Peter Steinberger anunciando OpenClaw, el nuevo nombre de Moltbot, que a su vez fue un nuevo nombre para Clawd. En cualquier caso, una plataforma abierta que, con sus luces y sus sombras, ha traído aire fresco al mundo de los agentes personales inteligentes alojados en nuestra propia infraestructura.

También, gracias a Kevin W. Griffin, esta semana he descubierto la función COUNT(*) OVER() de SQL Server, que permite obtener el número total de filas en una consulta sin necesidad de hacer una consulta previa adicional, muy útil para paginación de datos.

Teresa Torres, por su parte, ha publicado un post muy interesante explicando cómo funciona ChatGPT, con un lenguaje bastante más accesible para humanos "normales" que lo que solemos encontrar por la red.

Por último, David Grace nos recuerda que nuestras excepciones pueden exponer información sensible que podría ser utilizada por algún desalmado, y cómo evitarlo utilizando herramientas proporcionadas por ASPNET Core.

El resto de enlaces, a continuación.

Por si te lo perdiste...

- El código fuente de .NET muy a mano: source.dot.net

José M. Aguilar - Registro y obtención de múltiples implementaciones de servicios en ASP.NET Core, y un caso práctico

José M. Aguilar

.NET

- Exploring the (underwhelming) System.Diagnostics.Metrics source generators

Andrew Lock - Automatic Dependency Injection in C#: The Complete Guide to Needlr

Nick Cosentino - .NET Framework 3.5 Moves to Standalone Deployment in new versions of Windows

Tara Overfield & Brett Lopez - Your Encryption Is Broken — .NET Data Protection Done Right

Martin Stühmer - Reliably Refreshing the WebView2 Control

Rick Strahl - Encrypting Properties with System.Text.Json and a TypeInfoResolver Modifier (Part 2)

Steve Gordon

ASP.NET Core / ASP.NET / Blazor / Aspire

- Use client assertions in ASP.NET Core using OpenID Connect, OAuth DPoP and OAuth PAR

Damien Bowden - AI-Powered Smart TextArea for ASP.NET Core: Smarter Typing with Intelligent Autocompletion

Arun Kumar Chandrakesan - Getting Started With .NET Aspire 13: Building and Deploying an App With PostgreSQL, Redis, and Docker Compose

Anton Martyniuk - Are exceptions exposing vulnerabilities in your .NET App?

David Grace - Securing Aspire Apps with Microsoft Entra ID

Jean-Marc Prieur

Conceptos / Patrones / Buenas prácticas

- Your appsettings.json Is a Compliance Violation

Martin Stühmer - Your Idempotent Code Is Lying To You

Derek Comartin - Hierarchical Navigable Small Worlds

Amandeep Singh

Data

- SQL Server Pagination with COUNT(*) OVER() Window Function

Kevin Griffin - I Just Don’t Understand Why You Don’t Update SSMS

Brent Ozar - SQL Concatenate String using Double Pipe (||) Operator in SQL Server 2025

Rajendra Gupta - Enable Soft Delete in Azure SQL

Jerry Nixon

Machine learning / IA

- MCP Server como Proxy de otro MCP Server

Gisela Torres - Presentamos la aplicación Codex

OpenAI - Claude Opus 4.6

Anthropic - Introducing OpenClaw

Peter Steinberger - OpenClaw Full Tutorial for Beginners

Beau Carnes - Linear Regression with Pseudo-Inverse Training Using JavaScript

James McCaffrey - How Does ChatGPT Work? A Guide for the Rest of Us

Teresa Torres

Web / HTML / CSS / Javascript / UX

- Incremental Hydration in Angular: Build SSR Apps That Feel Instantly Interactive

Ankit Sharma - Build a Full-Featured PDF Editor in Angular for Modern Web Apps

Arun Kumar Chandrakesan - Combobox vs. Multiselect vs. Listbox: How To Choose The Right One

Vitaly Friedman - Making interesting borders with CSS corner-shape

Peter Ritchie - React Basics: Memoization in React

David Adeneye Abiodun - CSS Bar Charts Using Modern Functions

Preethi - Vue Basics: A Comprehensive Guide to Vue 3 Directives

David Adeneye Abiodun - CSS @scope: An Alternative To Naming Conventions And Heavy Abstractions

Blake Lundquist - Why Your UI Won’t Update: Debugging Stale Data and Caching in React Apps

Oluwadamisi Samuel

Visual Studio / Complementos / Herramientas

- No-Hassle Visual Studio Code Theming: Building an Extension & Publishing an Extension

Zell Liew - Roadmap for AI in Visual Studio (February)

Rhea Patel - WinGet Configuration: Set up your dev machine in one command

Rob Bernstein

.NET MAUI

- Introducing Bindable Property Source Generators

Brandon Minnick - Loading Dynamic Data into a .NET MAUI ComboBox with JSON and REST APIs

Sudarsan Muthuselvan - Replicating a Valentine-Inspired Login UI in .NET MAUI

Leomaris Reyes

Otros

- Tendencias clave en puestos de trabajo tecnológicos en España (2022-2026)

CampusMVP - Introducing the Google Developer Knowledge API and MCP Server

Jess Kuras

Publicado en Variable not found.

Picando Código

Números

febrero 05, 2026 10:30

Últimamente he ido identificando ciertos números "hito" tanto en este blog como en lo personal. Así que usé esos números como excusa para escribir.

Las ruinas de lo que queda de una comunidad rural de Drippan en Glen Finglas, Escocia.

En enero escribí mucho

En Enero de 2026, publiqué 16 entradas en el blog. Mirando el dropdown de archivos del blog, desde 2021 no escribía tantos posts en el mismo mes. En esa época estaba en pleno encierro post pandemia. Mentalmente me encontraba en un lugar bastante particular. Escribir en el blog era un escape y una forma de intentar conectar con el mundo exterior, aunque en su momento no tuve mucho éxito (estaba todo el mundo en un lugar particular en su cabeza).

Recientemente la motivación ha sido distinta. He estado escribiendo porque me gusta, porque tengo ganas y porque siento que tengo cosas para escribir. También he escrito cosas con las que estoy bastante conforme. Eso me motiva más a escribir y al estar en ese ritmo, me resulta más fácil y me surgen más ideas. Se ve que estoy en una etapa creativa, hay que seguir alimentándola. ¡Ojalá pudiera dedicarle más tiempo a proyectos creativos! Dijo toda persona con trabajo siempre.

El mes de febrero empezó bastante ocupadocon cosas fuera de la computadora así que recién estoy volviendo a escribir de nuevo. Tengo muchas cosas que quiero publicar, así que este fin de semana seguramente use un tiempo para ponerme al día.

Otra cosa que he notado en el blog es que han aumentado los comentarios, tanto en las entradas como a través de Mastodon. Muchas gracias a la gente que se toma el tiempo de dejar un comentario, es parte muy valiosa de un blog.

También veo los frutos de empezar a leer más blogs en español y conectar con más gente y directorios. Empiezo a sentir una ilusión de comunidad virtual como la que existía hace muchos años entorno a los blogs. Era cuestión de ponerle un poco de esfuerzo de nuevo. Por ejemplo leyendo un blog y reconociendo autores de otros blogs en los comentarios "¡A ese también lo leo!".

Números del blog

Al escribir esto tengo 317 entradas de borrador en el blog. Este año espero poder bajar ese número a algo más razonable. Muchas veces empecé a escribir algo y me quedé sin energía a mitad de camino, dejando un post sin terminar delegado al limbo de los borradores. Pero también estoy intentando no ser tan exigente con lo que publico. A veces unas pocas palabras sobre algo es mejor que nada, y me motiva a volver a escribir otra cosa más adelante. La constancia genera constancia.

Voy a tener que darme por vencido con un montón de cosas, eliminar el borrador y seguir adelante. Pero ya rescaté otro montón de entradas. Seguramente rescate alguna cosa más, y publique entradas que se puedan sentir "nostálgicas" llamémoslas porque las empecé hace años. Espero mantener esta constancia porque lo disfruto y me sirve de referencia para el futuro. Tengo borradores de 2008, algunos son sólo el título y no tengo ni idea qué quería escribir. Como experimento de repente hago una entrada a partir de esos borradores con tan poco contenido que ni idea por dónde venían. A ver qué sale.

Esta es la entrada 1784 en el blog. No es un número que se vea muy redondo, 1 + 7 es 8, 7 es primo y 8 y 4 son múltiplos de 2 y 2^2 y 2^3 respectivamente. Pero lo interesante es que la cosa se acerca a las 2.000 entradas. Veremos si llegamos. Estaría bueno celebrarlo de alguna manera, podría hacer sorteos del estilo que he hecho antes en el blog o algo más, pero me gustaría algo más interactivo. Si hice bien las cuentas, manteniendo un ritmo promedio de 9 entradas por mes en el blog, en 2 años estamos festejando esas 2.000 entradas.

Aproveché la movida de los números para escribir un poco de SQL y ver cuántos comentarios de usuarios hay (excluyendo pingbacks y trackbacks):

El resultado son 6862 comentarios de personas (incluyéndome). Casi 4 comentarios por entrada, ¡nada mal!

Cumpleaños de Picando Código

En junio de 2025, este blog cumplió 18 años en línea. Un montón de años para cualquier tipo de proyecto o página web. Es como una extensión de mi persona a esta altura. Me ha ido acompañando a lo largo de mi carrera, por etapas de más y menos constancia.

Bah, en verdad no es tanto una extensión de mi persona, sino una extensión del personaje de turno que esté a cargo en mi cabeza al momento de escribir cada entrada en el blog. De los delirion, opininones y sentimientos que elijo exponer públicamente a la internet a través de este medio. De distintos objetivos y motivaciones para escribir a lo largo de los años. Pero sí una expresión creativa que viene de mí.

Renové el dominio y hosting por un par de años más, así que el blog va a cumplir sus 20 años en línea en 2027. Si llega en línea al 2030, voy a haber vivido más años con Picando Código que años sin Picando Código. Quién sabe qué pasará en 2030, y si la vida en el planeta se sostiene hasta entonces con lo que viene pasando. Pero dejo acá una referencia en el tiempo, así tengo algo de qué escribir en 2030 y puedo hacer un flashback a esta entrada. Si leen esto y siguen acá entonces, pueden decir "¡yo me acuerdo de ese flashback!" en 2030.

Cumpleaños de Fernandito

En julio de 2025, cumplí 40 años, otro montón de años más. Qué buen año 1985, salió Super Mario Bros. y Volver al Futuro. No tengo mucho para escribir sobre el tema. Un mensaje que le daría a gente que va entrando a sus 30 es una advertencia que nunca me dieron. Los adultos nunca me avisaron que el pelo que perdemos en el cuero cabelludo crece en las orejas. Sí, a esta edad aparte de andar recortándose los pelos de la nariz, hay que afeitarse las orejas. Esta es parte importante de la sabiduría que he acumulado en mis primeras 4 décadas, por más a las órdenes, brebaje mediante.

Estamos en 2026, ¿se dan cuenta? 2025 no me sonaba tan especial porque es un múltiplo de 5 y siempre se sienten como puntos de referencia o fechas artificiales (cerebro funciona raro). Capaz mi mente está condicionada con los 5 porque me resulta fácil calcular mi edad en base a años que terminan en 5 (aparte de que sea la mitad del sistema decimal que usamos para todo). Pero 2026 se siente como un año bien en los dos miles.

Habiendo vivido el cambio de milenio, suena a año en pleno futuro. Estamos en el futuro y se siente como que de repente nos tendríamos que haber quedado con lo que teníamos al principio del milenio y no mucho más. Antes me preguntaba si tendríamos autos voladores y jetpacks. Ahora anhelo la abolición de los millonarios y que no se extinga la vida en el planeta a causa del capitalismo. Y dicen que uno se vuelve más conservador con la edad.

Creo que ya deliré suficiente con esto. Mejor la dejo acá...

Variable not found

¿Cuántos parámetros son demasiados parámetros?

febrero 03, 2026 07:05

Muchas veces habéis escrito métodos o funciones en las que recibís un parámetro, dos parámetros, tres, cuatro... Y seguro que alguna vez habéis llegado a un punto en el que habéis tenido la sensación de que el número de parámetros se os ha ido de las manos. En este momento, estaremos percibiendo el code smell llamado "Long Parameter List" o "Lista de Parámetros Larga", todo un clásico en el aromático arte de la programación ;)

Porque, indudablemente, cuando un método o función recibe demasiados parámetros puede volverse difícil de leer, entender y mantener, y son muy propensos a errores de codificación, sobre todo si los tipos de datos de los parámetros son similares o si su orden no es claro o intuitivo.

Pero, ¿cuántos parámetros son demasiados parámetros? ¿Cinco? ¿Diez? ¿Veinte? Como suele ocurrir, no existe una respuesta única y categórica sobre el tema, aunque sí existen algunas recomendaciones que pueden ayudarnos a tomar una decisión cuando nos enfrentamos a esta situación.

Los problemas de tener demasiados parámetros

Un método o función que recibe demasiados parámetros se considera generalmente un code smell. No es un error en sí mismo, pero suele indicar que algo no está bien diseñado y que probablemente necesite una revisión o refactorización.

El problema más evidente de tener demasiados parámetros es que automáticamente es más difícil de leer y entender. Cada parámetro adicional añade complejidad y puede hacer que el propósito del método o función sea menos claro, lo que puede llevar a confusiones y errores al utilizarlo. También, el código será más extenso, lo que puede extender el aroma a otros smells como Long Method, Primitive obsession, Feature Envy y más fragancias desagradables.

Además, si los parámetros son de tipos similares o tienen nombres poco descriptivos, es fácil que al invocar la función se ordenen de forma incorrecta, lo que en muchos casos puede provocar errores difíciles de detectar y corregir.

Y por supuesto, puede generar problemas de mantenimiento y escalabilidad del código. Si un método o función tiene muchos parámetros, cualquier cambio en su firma (añadir, eliminar o modificar parámetros) puede requerir cambios en múltiples ubicaciones, lo que aumenta la complejidad y el riesgo de introducir nuevos errores.

Pero también tiene implicaciones en el diseño de nuestro software. Usar demasiados parámetros puede ser un indicativo de que estamos violando el principio de responsabilidad única (SRP, por sus siglas en inglés), lo que significa que está haciendo demasiadas cosas a la vez y debería ser dividido en métodos más pequeños y específicos. Podría indicar igualmente una baja cohesión, porque es posible que los parámetros no estén relacionados entre sí y el ámbito del método sea demasiado amplio.

Pero, ¿cuántos parámetros son demasiados?

Como comentaba algo más arriba, no existe una respuesta única y definitiva a esta pregunta, pero sí hay algunas recomendaciones generales que pueden servirnos de guía.

Robert C. Martin, también conocido como "Uncle Bob", sugiere que el número ideal de parámetros es cero. Está claro, si un método no recibe ningún parámetro, no dependerá de ningún dato externo, por lo que no existirá código de validación, ni transformaciones de datos, ni la lógica dependerá de ellos. En definitiva, el método será más simple y directo y, a lo sumo, podrá operar con datos internos de su objeto o valores constantes; el código será más conciso, fácil de leer y entender. Todo ventajas 😉

Sin embargo, en el mundo real es un objetivo difícil de alcanzar, por lo que en la mayoría de escenarios, que nuestros métodos o funciones no tengan parámetros es más una aspiración teórica que otra cosa.

A partir de ese límite ideal, está claro que conforme va creciendo el número de parámetros, la complejidad del método también aumenta, y con ella la dificultad para entenderlo y mantenerlo. En su clásico libro Clean Code, Martin dice que usar más de tres parámetros debería requerir una justificación bien argumentada.

En general, la comunidad de desarrolladores está más o menos de acuerdo en que el ideal es que un método o función no reciba más de 3 o 4 parámetros. A partir de ahí, el código comienza a ser difícil de leer y mantener y es cuando se empieza a considerar que estamos ante un "code smell" que puede traernos problemas.

Steve McConnell, en su libro "Code Complete", establece que el máximo número de parámetros debería rondar los siete, basándose en el número mágico de la psicología cognitiva, propuesto por George A. Miller en 1956, que sugiere que el número de elementos que una persona puede retener en su memoria a corto plazo es de aproximadamente siete (más o menos dos).

Por tanto, la cosa queda así:

| Número de parámetros | Comentario |

|---|---|

| 0 | Ideal, aunque poco probable |

| 1-3 | Bien, fácil de entender y mantener |

| 4-7 | Sólo en casos justificados |

| 8+ | ❌ Evitar a toda costa |

Pero ojo, porque, como siempre, existen casos que pueden romper estas reglas generales. Un ejemplo clásico podría ser una función como la siguiente:

public int SumNineNumbers(

int n1, int n2, int n3, int n4, int n5, int n6, int n7, int n8, int n9)

{

return n1 + n2 + n3 + n4 + n5 + n6 + n7 + n8 + n9;

}

Si su misión es realizar una acción concreta que requiere un determinado número de valores de entrada, ¿sería incorrecto definirla con nueve parámetros? ¿O es lo que esperaríamos, dado el nombre de la propia función? En mi opinión, en este caso estaría totalmente justificado; cualquier refactorización para reducir el número de parámetros sería introducir una complejidad innecesaria.

¿Y qué alternativas tenemos?

Cuando ya estamos ante un método o función que define o va a definir demasiados parámetros, es importante detenernos a pensar cómo podemos mejorarlo.

En primer lugar, debemos preguntarnos por qué nuestro código necesita tantos datos de entrada. ¿Estamos haciendo quizás demasiadas cosas en el mismo método? ¿Tiene demasiadas dependencias? Si es así, es posible que estemos violando el principio de responsabilidad única (SRP) y deberíamos considerar dividirlo en varios más pequeños y específicos.

// Refactorizar esto:

public void ProcessAndNotifyOrder(

string orderId, string customerName, DateTime orderDate,

string notificationEmail, string notificationMessage)

{

// Lógica para procesar el pedido

// Lógica para notificar al cliente

}

// A esto:

public void ProcessOrder(string orderId, string customerName, DateTime orderDate)

{

// Lógica para procesar el pedido

}

public void NotifyCustomer(string notificationEmail, string notificationMessage)

{

// Lógica para notificar al cliente

}

Pero si realmente necesitamos recibir todos esos argumentos, existen distintas técnicas que pueden ayudarnos a reducir el número de parámetros y evitar problemas.

Por ejemplo, si estamos recibiendo siempre el resultado de haber usado un método, función o propiedad, quizás esa llamada debería realizarse desde dentro de nuestro propio código, como se muestra a continuación:

// Refactorizar esto:

public void Log(string message, string level, string source, DateTime now)

{

// Lógica para registrar el mensaje

}

// A esto:

public void Log(string message, string level, string source)

{

DateTime now = DateTime.Now; // Obtenemos el timestamp dentro del método

// Lógica para registrar el mensaje

}

También, si nuestro método o función recibe parámetros booleanos, deberíamos considerar revisarlo. Como vimos hace tiempo en el post "¿Usar booleanos? ¿Sí, no, a veces?", este tipo de parámetros suele introducir ambigüedad y confusión, ya que no siempre está claro qué significa cada valor. En su lugar, quizás podríamos usar dos funciones diferentes, cada una con un propósito claro y específico:

// Refactorizar esto:

public void Log(string message, string level, string source, bool isError)

{

// Lógica para registrar el mensaje

}

// A esto:

public void LogInfo(string message, string level, string source)

{

// Lógica para registrar el mensaje

}

public void LogError(string message, string level, string source)

{

// Lógica para registrar el mensaje

}

Otra posibilidad, que seguro habréis visto con cierta frecuencia, es el caso de métodos que reciben argumentos procedentes de un mismo objeto. En estos casos, podríamos considerar recibir el objeto completo en lugar de sus propiedades individuales:

// Refactorizar esto:

public void ProcessOrder(

string orderId, string customerName, string customerEmail, DateTime orderDate)

{

// Lógica para procesar el pedido

}

// A esto:

public void ProcessOrder(Order order)

{

// Lógica para procesar el pedido

}

Otra solución bastante habitual es usar la refactorización conocida como Introduce Parameter Object. Esta técnica consiste en agrupar varios parámetros relacionados en un único objeto, lo que reduce el número de parámetros y mejora la legibilidad del código.

Por ejemplo, podemos ver el resultado de aplicar esta técnica en el siguiente código:

// Refactorizar esto:

public Task<IEnumerable<Customer>> GetCustomersAsync(

int pageNumber, int pageSize, string sortBy, string filter, bool includeInactive)

{

// Lógica para obtener los clientes

}

// A esto:

public Task<IEnumerable<Customer>> GetCustomersAsync(CustomerQuery query)

{

// Lógica para obtener los clientes

}

Aparte, si el objeto de parámetros es muy complejo, puede ser útil combinar este enfoque con el patrón Builder, que permite construirlo paso a paso. Por ejemplo, podríamos tener un código como el siguiente:

// Refactorizar esto:

var query = new CustomerQuery

{

PageNumber = 1,

PageSize = 20,

SortBy = "Name",

IncludeInactive = false,

IncludeOrders = false,

IncludeAddresses = true

};

var customers = await GetCustomersAsync(query);

// A esto:

var query = new CustomerQueryBuilder()

.WithPageNumber(1)

.WithPageSize(20)

.SortedByName()

.IncludeAddresses()

.Build();

var customers = await GetCustomersAsync(query);

¡Espero que os haya resultado interesante!

Publicado en Variable not found.

Picando Código

Reemplazando Mozilla Firefox

enero 29, 2026 09:00

Como comenté en un post anterior, estoy dejando de usar Firefox. Una condición de este cambio es no usar un navegador web basado en el motor de Google Chrome. Google Chrome es el Internet Explorer 6 de éstos tiempos, así que quedan descartados un montón de navegadores web populares.

Hace tiempo que Mozilla parece estar buscando perder usuarios de Firefox de gusto. Pero el problema más notorio recientemente ha sido su compromiso con usar lo que los tecnofascistas millonarios cocainómanos de Sillicon Valley nos quieren vender a prepo con el término marketinero de "Inteligencia Artificial" ("IA" a partir de ahora, para acortar). Esto ha generado mucho rechazo (con razón) de una gran parte de sus usuarios. No quiero entrar en mi postura del tema de IA porque me entra a subir la presión y no es el tema de este post. Pero el consenso general parece ser que Mozilla debería preocuparse por hacer a Firefox el mejor navegador web posible, y no meterle IA a prepo.

Por suerte todavía hay muchas opciones, a continuación comento qué he ido haciendo. Potencialmente escriba más posts en el futuro sobre este tema. Definitivamente estoy prestando más atención recientemente al desarrollo de alternativas a Firefox, así que lo que vaya encontrando interesante lo compartiré por acá.

Descartado por ahora: GNU IceCat

GNU IceCat

En el pasado usé bastante IceCat, pero en algún momento dejaron de funcionar los repositorios o algo de eso. Tengo una instalación vieja en el directorio ~/bin de mi sistema, pero aparentemente no tiene la habilidad de actualizarse sólo a versiones más nuevas. Hace muchos años hasta escribí un post Usando IceCat como reemplazo de Mozilla Firefox: Perfiles de usuario. Esto de llevarme el perfil a otro navegador me puede resultar útil, pero ya veremos más adelante...

La página web de GNU IceCat dice: El proyecto actualmente no distribuye binarios, pero el gestor de paquetes GNU Guix puede ser usado para instalar IceCat en sistemas GNU/Linux. También hay instrucciones para hacer tu propia versión de IceCat con scripts del repositorio git de GNUzilla y el código fuente de Firefox. Todo bien, en algún momento de repente me interesaría aprender y probar Guix. Y compilar el código puede llegar a ser divertido. Pero en este momento estoy intentando reemplazar Firefox y no tengo tiempo.

Aparentemente sólo hay binarios de versiones no oficiales, y no encontré un PPA confiable como para agregar a APT. Hay uno con versiones arcaicas de IceCat que creo que lo encontré buscando en este mismo blog. Pero en fin, queda descartado porque no me inspira demasiada confianza su futuro. De repente con la cantidad de usuarios que nos vamos yendo de Firefox es un buen momento para volcar más recursos en el mantenimiento de IceCat, pero parece que ahora no es prioridad. Si remonta un poco la actividad, lo volveré a considerar.

Debian Iceweasel

Debian Iceweasel

En mi búsqueda pensé si no sería un bueno momento también para que vuevla Iceweasel. Entre Debian Etch y Debian Jesse la versión de Firefox empaquetada por Debian llevaba el nombre de Iceweasel. Esto era para no infringir con la marca registrada de Mozilla. El Firefox que venía en Debian no era "oficial", le aplicaban sus propios parches y cambios al navegador. Mozilla consideraba estos cambios fuera de su política, así que el paquete no se podía considerar "Firefox".

Más adelante Debian fue autorizado a volver a la marca de "Firefox" y Iceweasel desapareció. Esto es lo que recuerdo, pero seguramente falten muchos detalles. Sé que hay hasta una entrada en Wikipedia sobre la pelea por la marca registrada de Firefox entre Mozilla y Debian para leer más del tema.

Debian igual hace algunos cambios a la configuración por defecto de Firefox en su versión .deb. En esta wiki hay más detalles, aunque está muy desactualizada. Ahí mismo comentan: "Firefox hace una serie de conexiones automatizadas a servidores de Mozilla (y de otros) sin pedir la aprobación explícita del usuario". Así que están pendientes de la telemetría y los problemas de privacidad de Firefox.

Es posible que en algún momento consideren que el desarrollo de Firefox diverge tanto de lo que es aceptable en Debian, que decidan volver a hacer su propia versión. Ya hay un bug reportado de 2025 donde cuestionan que los nuevos términos de uso de Firefox sean compatibles con Debian. En la conversación está Sylvestre Ledru, desarrollador de Debian desde hace muchos años y director en Mozilla, involucrado en su momento con el tema Iceweasel/Firefox. También Mike Hommey, uno de los desarrolladores más prolíficos de Mozilla en número de commits, empleado de Mozilla y quien estuvo manteniendo Firefox/Iceweasel en Debian muchos años.

Sería interesante, veremos qué pasa. Tanto hablar de Debian me dieron ganas de volver a Debian...

Waterfox y LibreWolf

De la poca investigación y lo que he fui leyendo, éstos dos parecen ser los forks más populares de Firefox éstos días. Instalé ambos, pero a lo que empecé a usar Waterfox y todo funcionó bien, me quedé con eso. Tengo instalado LibreWolf, pero sinceramente no lo he usado mucho.

Waterfox

Waterfox

Encontré una guía de instalación que usaba el repositorio APT de OpenSUSE (Hola OpenSUSE, ¡tanto tiempo!). Pero poco después me enteré que el repositorio dejó de ser mantenido, así que no recibiría más actualizaciones. Así que descargué el binario para Linux desde la página web oficial y desinstalé el deb. Por suerte todo siguió igual, la versión instalada a mano levantó el mismo perfil que la anterior.

También lo instalé en mi teléfono y lo sincronicé con la versión del escritorio. Todo funcionó bien. Pensé en hacer lo que comentaba en la sección de IceCat, de importar mi perfil de Firefox y mantener la experiencia. Pero aproveché la oportunidad para empezar de cero y tener una experiencia limpia.

Me importé todos los Favoritos (o Bookmarks) de Firefox. Instalé sólo un par de extensiones, ya ni recuerdo cuáles venían instaladas y cuáles no. Pero esenciales son uBlockOrigin y una que descubrí gracias a FireDragon: Dark Reader. Agrega la opción de tener "modo oscuro" para cualquier página, muy conveniente para no quedar encandilados en páginas con fondo blanco. Ya no puedo usar el escritorio de WordPress sin Dark Reader...

Desde que Mozilla paró el desarrollo de Lockwise, migré mis contraseñas a Bitwarden. Instalé la extensión de Bitwarden para mis passwords, y listo. En principio tenía Firefox Nightly y Waterfox funcionando a la vez. Entonces si necesitaba algo de Firefox me lo traía a mano. Pero hace bastante ya que no necesito abrir Firefox.

Personalicé un poco la interfaz de usuario a mi gusto. Creo que por defecto traía la barra de estado, algo medio old school que ocupa un poco de espacio en la parte inferior de la pantalla. De ahí saqué el botón para sacar capturas de pantalla, una herramienta que uso seguido, y lo moví a la barra superior junto al menú de favoritos y extensiones.

Creé varios contenedores, un invento excelente de Mozilla cuando todavía eran buenos. Me creé contenedores específicos para servicios, por ejemplo todo lo que sea de Google corre en su contenedor. Con la opción de abrir siempre esas páginas en el contenedor, no tenemos ni que pensar. Aproveché la mudanza para usarlos mucho más y tener perfiles de navegación separados dentro del mismo navegador.

Una característica genial de Waterfox es que te permite abrir pestañas privadas en la misma ventana de navegación que estás usando para las pestañas comunes. Hasta donde sé, Firefox no tenía esta característica, sólo abrir enlaces en ventanas nuevas privadas.

Waterfox publicó en su blog una respuesta directa al uso de IA por Mozilla: No AI* Here - A Response to Mozilla's Next Chapter. La parte que concierne a inclusión de AI en el navegador se resume en "Waterfox no incluirá LLMs. Punto y aparte. Al menos y definitivamente no en su forma actual ni en el futuro previsible".

Después de esos primeros días donde personalicé y dejé el navegador a gusto, todo viene funcionando bien, como esperaba. No noto muchas diferencias con Firefox, de repente anda mejor, pero puede ser porque en Firefox tengo cientos de pestañas abiertas, algunas de hace muchos años... Y el perfil de usuario lo vengo arrastrando hace años en distintas versiones de Firefox y de Sistemas Operativos. Uh, otra cosa que agregaron en la última versión de Waterfox que está muy buena es "des-cargar" pestañas (des cargar onda de sacarlas de la memoria) desde el menú contextual. Hacemos clic derecho en una pestaña y nos aparece la opción.

El paso que me queda es un día sentarme a recorrer todas esas pestañas que tengo abiertas en Firefox, exportar a favoritos las cosas que quiere leer o volver a visitar, y cerrar el resto. Así finalmente voy a poder desinstalar Firefox y olvidarme del tema. Pero como navegador principal por ahora vengo usando Waterfox y estoy conforme.

LibreWolf

LibreWolf

Como mencioné, no llegué a usar mucho LibreWolf. Pero no veo por qué no sería una buena opción para reemplazar Firefox.

Es un fork popular y sus metas son la privacidad, seguridad y libertad de los usuarios. Está diseñado para mejorar la protección contra técnicas de rastreo y fingerprinting, e incluye mejoras de seguridad a través de opciones por defecto y parches. También elimina toda la telemetría, colección de información y molestias, y deshabilita características anti-libertad como DRM. Esto último podría ser un problema a la hora de usar servicios de streaming imagino, pero seguro hay alguna vuelta para solucionarlo.

Incluye uBlockOrigin por defecto, esa extensión esencial. Hace años que no tengo ni idea cómo se ven los anuncios en la web, y cada vez que veo uno en la pantalla de otra persona me agobio. El gestor de contraseñas viene deshabilitado, recomiendan usar un gestor mejor y entre las opciones sugieren Bitwarden.

Su repositorio de código está alojado en Codeberg. No tienen versión de Android, pero recomiendan IronFox como alternativa, un proyecto que voy a revisar y tener en cuenta.

FireDragon (Garuda Linux)

FireDragon

Además de KDE Neon como distribución principal, también vengo usando Garuda Linux. En ese sistema no tuve que hacer nada porque el navegador web por defecto es FireDragon:

FireDragon es un navegador basado en el excelente navegador Floorp (también llamado el Vivaldi de los Firefox). Fue personalizado para tener una estética similar al sistema así como muchas preferencias opinionadas por defecto. Como este navegador era originalmente un fork de Librewolf, estamos tratando de integrar sus mejores parches y cambios en la base nueva.

Floorps es otra opción a tener en cuenta, pero en lo personal no me interesó. Tienen una postura definida, distinta a Mozilla, en cuanto al uso de IA: No respaldamos completamente ni rechazamos explícitamente IA. Respetamos las decisiones de los usuarios que quieren usar IA y de los que no. Cualquier característica de IA agregada a Floorp será en base de optar por usarlo. Van a estar desactivados a menos que sean habilitados por el usuario.

A tener en cuenta, en esa misma página hacen un comentario bastante ridículo: Para mantener un paso de desarrollo que soporte a usuarios en todo el mundo, es esencial la asistencia de herramientas de IA (como GitHub Copilot). Si van a usar esas porquerías, háganse cargo, no salgan con ese bolazo de que es "esencial".

Además de las preferencias de Floorps, FireDragon tiene un montón de personalizaciones. Cuenta con Firefox accounts pero usa un servidor de sincronización a medida. Un detalle visual es que cuando un botón está deshabilitado (por ejemplo los botones de navegación adelante y atrás si no hay nada adelante o atrás), desaparecen en vez de quedar en color gris. Si bien es el navegador de Garuda Linux, se puede instalar en otros sistemas. Está disponible en AUR, NixOS, Flatpak, AppImage y binarios para Linux y los otros sistemas privativos.

FireDragon, el navegador web de Garuda Linux (ArchLinux) corriendo en KDE Neon (Ubuntu)

Tor Browser

Tor Browser

Tor Browser es el navegador web del proyecto Tor. Si no conoces el proyecto Tor y el navegador, este es un buen lugar para empezar. La misión de Tor es:

Promover los derechos humanos y las libertades mediante la creación y despliegue de tecnologías de anonimato y privacidad libres y de código abierto, el apoyo a su disponibilidad y utilización sin restricciones y el fomento de su comprensión científica y popular.

Tengo el navegador instalado, pero no lo uso mucho. No tengo mucha necesidad, creo. Cuando quiero un poco de privacidad extra me conecto a la VPN y uso el siguiente navegador. Se siente como que cargar las redes de Tor con mi uso de repente le puede quitar ancho de banda a gente que realmente lo necesita. Pero es una buena opción si necesitamos privacidad y no contamos con VPN.

Mullvad Browser

Mullvad Browser

Mullvad es el navegador web creado por Tor Project y distribuido por Mullvad. Mullvad es mi proveedor actual de VPN (¿ya vieron la gema Ruby que hice para eso?).

Usar una VPN no es suficiente para mantener el anonimato en línea. Las empresas usan todo tipo de estrategia para identificar y rastrear nuestra actividad. El navegador web puede ser usado para identificarnos por la información que comparte con los sitios web. Algunos navegadores son peores que otros en ese aspecto.

El navegador de Mullvad es lo mismo que Tor Browser pero sin la red Tor. Aprovecha todas las características orientadas a la privacidad y se integra con Mullvad VPN. Usa la estrategia "esconderse entre la multitud", con configuraciones y preferencias que hacen que todos los usuarios del navegador se vean parecidos para estas empresas que intentan identificarnos.

Este es el navegador que uso con la VPN para la mayor privacidad.

Pale Moon

Pale Moon

Escribí sobre Pale Moon en el blog hace poco. Recomiendo leer ese post para ver más. Además de lo ya dicho, también hicieron pública su postura respecto a incluir IA en el navegador: No, Pale Moon no va a integrar IA en sí mismo de ninguna manera, forma o modo. Coincido con su desarrollador que esto de meter IA hasta en la sopa es uno de los errores más grandes que viene haciendo actualmente el sector IT en su conjunto.

Pale Moon es de los navegadores que venía usando en paralelo con Firefox desde hace un buen tiempo. Me parece bueno eso de tener distintos navegadores para distintos perfiles de navegación. Particularmente cuando cada vez es más lo que hacemos a través de la web. También espero que ayude con el tema de la identificación, que los anunciantes y otras empresas nefastas intentando compilar información y rastrear actividades en línea les cueste más si no usamos siempre el mismo navegador web.

Pale Moon es una buena opción. No probé usarlo como reemplazo total a Firefox, pero imagino que no tendría demasiado problema. En el peor de los casos si algo no funciona, es una buena oportunidad para replantearse si realmente uno necesita visitar la página. Y como respaldo, siempre podemos abrir la página en otro de los navegadores de esta lista.

SeaMonkey

SeaMonkey

Le tengo muchísimo cariño al navegador web SeaMonkey. Lo vengo usando hace muchísimos años, potencialmente desde sus inicios. En su momento usaba la Mozilla Application Suite, el paquete de aplicaciones para Internet con un navegador, cliente de correo, lector de noticias, desarrollador de páginas web y cliente para IRC. SeaMonkey continúa el desarrollo de ese paquete con actualizaciones de alta calidad.

El proyecto está en constante desarrollo, la versión más actual se publicó el 31 de diciembre de 2025. Tuvo algunos problemas con las actualizaciones automáticas por una migración que están realizando de Azure a OSUOSL, una organización sin fines de lucro trabajando en el avance de las tecnologías de código abierto. El blog de SeaMonkey se actualiza relativamente seguido. Es un buen recurso para ver cómo avanza el proyecto.